Algoritmi dei motori di ricerca

Come ragionano i motori di ricerca? Quali sono gli algoritmi dei motori di ricerca? Quali sono le strategie da adottare in ottica SEO per migliorare il posizionamento delle pagine nelle SERP?

In questo articolo, voglio analizzare gli algoritmi dei motori di ricerca in ottica SEO. Google e gli altri “search engine” utilizzano algoritmi per classificare le informazioni archiviate sulla base di determinati parametri, non tutti noti. Questo processo permette di assegnare un valore ad ogni pagina web, valore che determina la posizione della pagina nella lista dei risultati (SERP) dei motori di ricerca. L’obiettivo primario è quello di fornire risultati che soddisfino pienamente le query effettuate dagli utenti. Un errore è però credere che Google, Yahoo e Bing utilizzino un solo algoritmo, quando in realtà sono diversi. Ognuno di essi assolve ad uno specifico compito e per questo è importante conoscerne almeno le principali caratteristiche e sfruttarle in ottica SEO. Non pretendo di coprire l’argomento in maniera esaustiva, ma di dare delle linee guida da utilizzare per l’ottimizzazione dei siti. Una risorsa molto importante da consultare è Search Engine Land, un portale sempre aggiornato sulle tematiche SEO, SEM, motori di ricerca. Segnalo anche SEJ (Search Engine Journal). Entrambi i siti sono in inglese.

Algoritmi di Google

L’algoritmo generale di ricerca di Google si chiama “HUMMINGBIRD“, rilasciato il 30 agosto 2013, il cui obiettivo è quello di gestire al meglio le “ricerche conversionali” in modo da far emergere pagine che siano il più possibile attinenti alla ricerca effettuata. Hummingbird agisce sul significato delle parole chiavi, sulle frasi di ricerca e sulla qualità dei testi inseriti all’interno di una pagina web. Questo algoritmi influenza oggi la quasi totalità dei risultati nelle SERP. Hummingbird non è ovviamente l’unico algorimo di Google. A seguire un elenco dei diversi algoritmi (vecchi e nuovi) utilizzati da Google, ognuno con una sua specifica funzione:

- Panda e PayDay per combattere lo spam;

- Penguin, per trovare e penalizzare tutti quei siti che hanno scalato le SERP con tecniche di “keyword stuffing” o “link buildind artificiali”;

- Pigeon progettato per migliorare i risultati di ricerca locali;

- Top Heavy, che ha il compito di abbassare il ranking di siti ricchi di pubblicità;

- Mobile Friendly (“Mobilegeddon”) costruito per premiare le pagine web “mobile-friendly”, ovvero ottimizzate anche per i dispositivi mobile;

- Pirate progettato per combattere le violazioni di copyright e quindi i “siti pirata” che mettono a disposizione film, musica, libri, software e videogiochi illegali. L’intenzione è quella di penalizzare tali siti eliminandoli dalle prime pagine delle SERP. Per maggiori informazioni potete leggere il seguente articolo “9 Outcomes Of Google’s Pirate Algorithm: Should You Be Concerned?;

- PageRank, forse il più conosciuto, che fornisce un valore, “rank”, alle pagine di base dei link di ingresso al sito (“backlink”);

- Hilltop, che valuta l’autorevolezza di un sito o di una pagina web su un particolare argomento;

- Stemming, algoritmo, basato sull’ IR (Information Retrieval), utilizzato di Google per aumentare significativamente il numero dei risultati (potenzialmente interessanti per l’utente) nella lista dei risultati di ricerca.

Dal 2015 Google sta usando un nuovo algoritmo basato sull’intelligenza artificiale, RankBrain, per aiutarsi nella scelta del ranking dei propri risultato di ricerca. L’obiettivo è chiaramente quello di migliorare l’accuratezza della ricerca e di ottenere risultati più precisi. RankBrain è un algoritmo che viene soprattutto utilizzato per interpretare le query di ricerca fatte dagli utenti su Google e tradurle in maniera efficace in modo da individuare le pagine più adatte. Il RankBrain è uno dei principali fattori del loro algoritmo di ranking, il che significa che le parole chiave a corrispondenza esatta non sono importanti tanto quanto la creazione di pagine e articoli tematici completi per i visitatori. Da un lato, Google sta lavorando duramente per migliorare l’accuratezza della ricerca, comprendendo l’intento del ricercatore e interpretando i suggerimenti contestuali di diversi siti web.

Algoritmo Panda

Algoritmo introdotto da Google a fine febbraio 2011, giunto alla versione 4.2, allo scopo di penalizzare i siti a bassa qualità, con contenuti duplicati o di spam, valorizzando allo stesso tempo siti web/blog che contengono contenuti originali e di informazione. Le indicazioni SEO che se ricavano, al fine di evitare penalizzazioni da parte di questo algoritmo, sono le seguenti:

- creare contenuti freschi e di utilità;

- curare la forma e la sintassi;

- evitare di copiare contenuti;

- non intasare le pagine di pubblicità, limitando ad esempio il numero di banner e facendo in modo che non infastidiscano la lettura del contenuto;

- applicare le tecniche “white SEO” e non “black SEO”.

Un altro consiglio è quello di assicurarsi che il contenuto della pagina web sia corrispondente alla parola chiave attraverso la quale vogliamo farci trovare dai motori di ricerca. Se non lo fosse possiamo inserire una o 2 extra-paragrafi che contengano la parola chiave stessa.

Algoritmo Penguin

Algoritmo utilizzato per verificare la qualità dei link in ingresso al sito, con l’obiettivo di penalizzare quei siti che ottengono link in maniera non naturale. A settembre 2016 Google ha rilasciato la versione finale (4.0) inserendola nel core dell’algoritmo di ricerca principale. L’algoritmo è ora in grado di valutare in tempo reale se un sito debba essere penalizzato o, viceversa, se gli possa essere tolta la penalizzazione. Tutto questo è sicuramente molto interessante, ma la domanda che mi sorge spontanea è: come facciamo a controllare tutti i links in ingresso al nostro sito o blog, soprattutto se ha un traffico elevato e rimuovere quelli che ci possono penalizzare ? Vi dico già subito che non esiste un sistema che in maniera automatica verifica i links e rimuove quelli “malevoli”, ma o ci si rivolge ad una agenzia specializzata o ci si deve armare di pazienza. Il primo passo da compiere è ovviamente quello di individuare i links “malevoli” ovvero quelli generati da noi attraverso tecniche di link building aggressive oppure quelli che si ricevono in modo spontaneo da altri siti e che non riusciamo a controllare. Un consiglio, fate questi controlli non appena il vostro sito o blog viene pubblicato o indicizzato o vi troverete migliaia di links in ingresso “fuori controllo”. Dopo aver individuato tali collegamenti inserite in un file (disavow file) la lista di tutte le URL in entrata da eliminare e comunicatelo a Google. La procedura da utilizzare è ben indicata nella “Guida di Search Console” al seguente link: Rifiuto dei backlink.

Algoritmo Pigeon

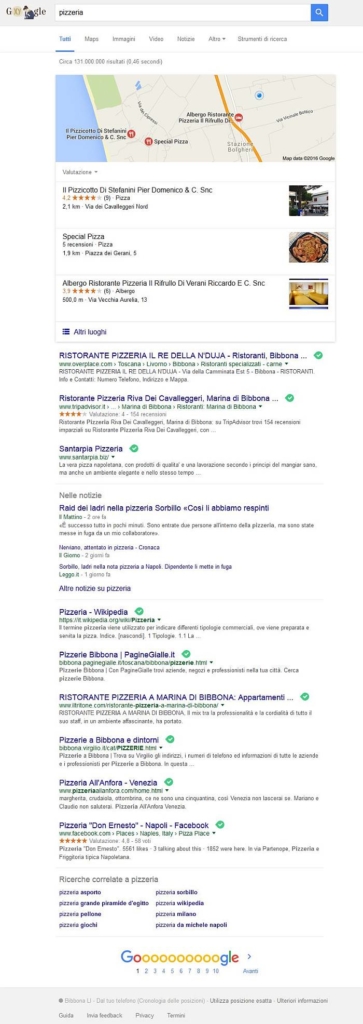

Questo algoritmo è stato progettato per fornire risultati più pertinenti ed accurati nelle ricerche locali e l’obiettivo è stato raggiunto integrando i risultati restituiti dalla ricerca classica con quelli di Google Maps. In passato per cercare ad esempio una pizzeria in una località, si doveva inserire una parola chiave composta da “pizzeria” + “località”. Ad esempio in questi giorni ero a Marina di Bibbona per lavoro e avevo bisogno di trovare un locale dove andare a mangiare una pizza. Ho acceso il mio portatile e digitato la parola chiave “pizzeria”. Il risultato, che si commenta da solo, è stato questo:

Questo algoritmo ha ovviamente portato a delle modifiche nelle SERP locali. Molti siti web hanno visto modificarsi il posizionamento nell’elenco dei risultati a discapito di altri. Pigeon è stato infatti progettato per avvicinarsi maggiormente alle ricerche locali che vengono fatte attraverso i dispositivi mobile. Per cui se stiamo cercando un locale nelle vicinanze di dove vi trovate in quel momento, grazie anche alla geolocalizzazione, vi verranno restituiti risultati a poca distanza dal luogo dove siete.

Vi segnalo un paio di articoli che trattano in dettaglio questo algoritmo, il suo impatto sulle SERP locali e come sfruttarlo per migliorare il posizionamento del vostro sito: Google Pigeon e Google Pigeon local update.

[Aggiornamento settembre 2016] Google stà già testando in USA il nuovo algoritmo che andrà ad impattare sulle “local search” e di conseguenza sulla “local SEO”, Google Possum. Di local SEO e del nuovo algoritmo di Google ne parleremo in un nuovo articolo. Chi non volesse può leggere il seguente articolo: Everything you need to know about Google’s ‘Possum’ algorithm update

Algoritmo Top Heavy

Questo algoritmo penalizza i siti con troppi banner pubblicitari posizionati nella parte superiore. Il motivo è semplice: la pubblicità su Internet negli ultimi anni è diventata molto aggressiva e spesso peggiora la navigazione sul sito che si vuole visitare. L’intento di Google è quello di avvantaggiare i siti che danno più importanza ai contenuti (che devono essere immediatamente visibili), rispetto alla pubblicità. “Top heavy” viene applicato solo a siti con annunci statici in posizioni fisse sulle pagine e non a quelli che utilizzano i pop-up, pop-under o annunci overlay. Anche se non viene specificato il numero massimo di annunci statici che si possono pubblicare, il consiglio è di non superare le 3 unità, utilizzando quelli ad alta conversione (728 x 90, 336 x 280, 160 x 600).

Algoritmo Mobile Friendly (“Mobilegeddon”)

A partire dal 21 aprile 2015 l’importanza di avere siti responsive, ovvero ottimizzati anche per i dispositivi mobile, è cresciuta moltissimo e di conseguenza il suo peso nel calcolo del ranking e quindi nel posizionamento sulle ricerche da mobile. Ricordo inoltre che ha partire da maggio 2016 Google ha di fatto aumentato l’effetto dell’algoritmo su tali risultati di ricerca. L’obiettivo è quello di aiutare gli utenti a trovare più contenuti interessanti e di qualità, ottimizzati per dispositivi come tablet e smartphone. Stiamo comunque parlando di ricerche effettuate da tali dispositivi, quindi questo algoritmo in teoria non dovrebbe incidere sulle ricerche effettuate da PC desktop. Nella realtà dei fatti godranno di un posizionamento migliore quei siti che risultino “mobile-friendly”, ovvero siti responsive o comunque adatti alla visione su smartphone e tablet.

Come rendere il nostro sito web “mobile-friendly”?

Esistono 3 principali approcci per rendere un sito correttamente visibile su smartphone:

- utilizzare un “design responsive” in cui la pagina rimane la stessa (URL, HTMP, Immagini) per ogni dispositivo ma cambia il CSS (la pagina viene formattata sulla base della lunghezza dello schermo). Questo approccio è quello preferito da Google;

- RESS/Adapting/Dynamic Server. L’URL rimane lo stesso ma il server invia una differente versione dell’HTML e CSS sulla base del tipo di device che effettua la richiesta;

- creare un sito mobile separato. Viene creato un sito che viene visualizzato solo per i dispositivi mobile, normalmente inserito in un sottodominio o una sotto-directory. Se tale approccio permette di adottare sia strategie SEO che di Advertising differenti, il lavoro da fare è praticamente doppio.

Strategie da adottare per migliorare il posizionamento nelle SERP?

Partiamo dal fatto che avere un sito mobile-friendly è un fattore di ranking, per cui meglio lo realizziamo è più potremo migliorare il posizionamento del nostro sito nelle SERP generali. La prima cosa da considerare è la velocità di caricamento delle pagine. “Accelerated Mobile Page Project” (AMP) è un progetto che consente di velocizzare il caricamento dei contenuti. Il progetto si basa su AMP HTML, un framework aperto e costruito interamente sulla base di tecnologie web esistenti, che permette la costruzione di pagine web più leggere. Produrre contenuti in questo formato porta dei notevoli vantaggi, tra cui la possibiltà di sfruttare i “caching server” di Google. Un altro accorgimento è quello di non usare Banner nelle sidebar.

NB: se il vostro blog è realizzato con WordPress potete utilizzare il plugin “Amp for Wp“.

Se volete verificare se il vostro sito è “mobile-friendly” è sufficiente effettuare il test che Google ha messo a disposizione e che trovate al seguente indirizzo: test di compatibilità Google con i dispositivi mobile.

Algoritmo PageRank

Il PageRank è un algoritmo che fornisce un valore numerico, o rank, a ciascuna pagina web indicizzata e viene utilizzato per misurarne la qualità, partendo da un valore zero per arrivare fino a 10. Il PageRank viene calcolato conteggiando sia la quantità di link esterni in ingresso, sia valutandone la qualità, intesa come grado di pertinenza rispetto all’argomento trattato.

![]()

Dal punto di vista SEO, per migliorare il valore del PageRank (aggiornato da Google ogni 3 mesi), occorre puntare ad una strategia di link building corretta. Per maggiori informazioni leggete l’articolo “Google PageRank.

Algoritmo Hilltop

L’algoritmo Hilltop è stato sviluppato da Bharat e Mihaila presso l’università di Toronto e reso noto al pubblico nel 1999. Google ne ha acquistato il brevetto nel 2003 per correggere uno dei limiti dell’algoritmo di PageRank, ovvero non distinguere link che arrivano da “pagine esperte” sull’argomento specifico (link rilevanti) o link che arrivano da pagine importanti e prestigiose in generale ma che non sono rilevanti rispetto al contenuto della nostra pagina web. Google utilizza questo algoritmo per l’ordinamento dei risultati sulla base della autorevolezza di un sito o di una o più pagine web rispetto ad uno specifico argomento.

Come funziona l’algoritmo di Hilltop?

L’algoritmo utilizza “pagine esperte” e i collegamenti su queste pagine per classificare i documenti. Le “pagine esperte” sono pagine che riguardano uno specifico argomento e hanno collegamenti verso altre pagine scritte da autori di organizzazioni non affiliate (es. Dmoz, Yahoo!, Wikipedia, siti universitari, bibliografie, librerie, ecc. ). Le pagine con maggiori collegamenti ipertestuali provenienti dalle pagine esperte sono considerate delle autorità sull’argomento in questione.

L’algoritmo Hilltop scarta tutte le pagine non autorevoli sull’argomento, correggendo i risultati derivanti dalla link popularity e dal PageRank che invece prende in considerazione tutti i link esterni o backlink provenienti da qualsiasi risorsa sul web. Agisce inoltre sullo spam generato dai link non rilevanti, riducendolo.

Punto di debolezza

Il punto centrale di Hilltop è dunque la determinazione delle “pagine esperte”, che però può essere visto anche come punto di debolezza dal momento che è molto facile trovare pagine esperte su argomenti molto popolari (ad elevato traffico), ma lo è meno nel caso di tematiche meno popolari o di nicchia, dove il rischio è di non riuscire a trovare un numero adeguato di pagine esperte per un corretto ordinamento dei risultato.

Hilltop e SEO

Ai fini SEO dobbiamo fare in modo che la nostra pagina sia collegata a pagine pertinenti e rilevanti (“pagine esperte”). Un modo possibile è quella di inserirla in directory ritenute esperte sull’argomento trattato. Un’altra strada da percorrere in parallelo è quella di ottenere link da pagine web che a loro volta ricevano link di qualità da pagine/siti ad alto rank.

Algoritmo di Stemming

Le tecniche di stemming sono studiate in informatica da oltre 40 anni e rappresentano uno dei metodi di base per ridurre la dimensionalità dei documenti di testo. Ma che cosa si intende per Stemming ? Lo stemmingè il processo di riduzione della forma flessa di una parola alla sua forma radice, detta tema. Il tema non corrisponde necessariamente alla radice morfologica (lemma) della parola: normalmente è sufficiente che le parole correlate siano mappate allo stesso tema (ad esempio, che andare, andai, andò mappino al tema and), anche se quest’ultimo non è una valida radice per la parola [fonte Wikipedia].

Questa definizione può sembrare chiara agli addetti ai lavori, ma proviamo a dirla in un altro modo. Stemming deriva dall’inglese stem, che significa stelo. Lo stelo è un elemento sottile ed allungato con funzioni di sostegno e collegamento (ad esempio gambo dei fiori). Nello stemming la radice di una parola viene considerata come uno stelo da cui si diramano tutte le parole varianti, per cui alla radice vengono associate più parole.

Come viene applicato lo stemming ai motori di ricerca ?

Il processo di stemming è utilizzato nei motori di ricerca per l’espansione della query effettuata dagli utenti su più documenti rilevanti, rendendo il processo di ricerca più efficace ed ampliando i risultati di ricerca attraverso l’inclusione di parole chiave simili. Questo è reso possibile dalla riduzione delle parole chiave alla radice corrispondente. Se volete approfondire l’argomento vi consiglio un ottimo articolo scritto da Andrea Minini: Algoritmo di Stemming.

Algoritmo di Stemming e SEO

Per sfruttare a proprio vantaggio lo Stemming, si possono seguire le linee guida di Google:

- creare gli articoli utilizzare un linguaggio naturale e comprensibile sia dagli utenti che dai motori di ricerca;

- ottimizzare una pagina ai fini di una ricerca esatta. L’argomento trattato deve essere chiaro sia a chi ci legge, sia agli spider dei motori;

- all’interno delle pagine spaziare le parole che devono essere spaziate;

- nei nomi, directory e file utilizzare sempre il separatore di parole classico (-) piuttosto che l’underscore (_) ed evitare di scrivere le parole attaccate;

- suddividere gli argomenti affrontati nel sito in cartelle nominate correttamente (non sempre applicabile);

- inserire la parola chiave principale nel dominio, fornendo contenuti di qualità ed inerenti con l’argomento indicato nella keyword, altrimenti il vostro dominio potrebbe essere considerato come SPAM.

Algoritmi di Yahoo e Bing

Yahoo! Search e Bing sono i motori di ricerca più utilizzati dopo Google, soprattutto negli Stati Uniti (in Italia la percentuale di utilizzo di Google supera il 90%) ed entrambi presentano caratteristiche di ottimizzazione SEO differenti. Solo a fini informativi è importante ricordare come dal 29 luglio 2009 Yahoo! e Microsoft hanno stretto un accordo di collaborazione che prevede, tra le altre cose, che Yahoo! Search utilizzi i risultati di ricerca forniti da Bing.

Yahoo utilizza un algoritmo che valuta il contenuto del sito e la keyword density, penalizzando i siti che hanno un valore di densità troppo alto (siti spam) o troppo basso (siti di scarsa rilevanza). Anche se sono poco propenso a dare dei valori di riferimento, in alcuni articoli viene indicato come valore ottimale di keyword density nel corpo della pagina attorno al 3%. Stesso valore per il meta tag keywords e description, che diventa 20% per il TITLE. Il mio consiglio quando scrivete un testo è sempre il solito: non preoccupatevi delle percentuali, ma create contenuti utili agli utenti e di facile lettura (scrittura naturale).

Bing è il portale di ricerca di Microsoft nato nel giugno del 2009 in sostituzione dei precedenti MSN e Live Search. In termini SEO Bing, a differenza di Google, da grande importanza ai meta tags ed alla posizione delle keywords nel testo (keywords prominence). Bing consiglia di utilizzare per la ricerca parole chiave ad esatta corrispondenza e di inserirle ove possibile (dominio, meta decription, tag del titolo H1 e H2), Google no (non sono fattori di ranking). Bing dà maggior peso inoltre alle parole chiave più in alto nel testo. Altri fattori di posizionamento SEO da tenere in considerazione, se l’obiettivo è quello di essere anche indicizzati su Yahoo! Search, sono:

- età del dominio (più è vecchio e più sarà rilevante). Una delle strategie da utilizzare in questo senso è di acquistare domini già esistenti;

- parola chiave principale nel dominio;

- presenza della parola chiave nel tag TITLE;

- contenuti di qualità e lunghi almeno 300-500 parole per pagina;

- struttura della pagina web, in modo che sia facilmente navigabile (utilizzo tag H1, link building interna, “breadcrumps” e URL semplici e non lunghi);

- codice del sito pulito e che rispetti la validazione HTML (W3C);

- link in entrata ed in uscita. Bing dà meno peso alla link building rispetto a Google. Tuttavia una buona strategia di “link in ingresso” può essere utile, soprattutto se le pagine web da cui arriva il collegamento contengono la parola chiave del vostro sito nel tag TITLE. Bing considera invece maggiormente i link in uscita dal proprio sito, purché i siti web esterni a cui viene indirizzato il collegamento siano ritenuti rilevanti, oltre che utili ai fini di un approfondimento del contenuto della vostra pagina. In ogni caso sia che ottimizzate per Google che per Bing cercate di linkare siti considerati autorevoli.

- utilizzo di segnali social. La condivisione social influenza direttamente il posizionamento delle pagine web nella SERP del motore di ricerca di Microsoft;

Bing e l’Adaptive Search

A partire dal 2011 il motore di ricerca di Microsoft sta utilizzando un tipo di approccio chiamato Adaptive Search, con l’obiettivo di risolvere il problema dovuto all’ambiguità dei termini utilizzati nella ricerca. Parole identiche possono avere infatti diversi significati. Come può allora un motore di ricerca capire quello che effettivamente stiamo cercando? Semplicemente, ma non troppo, sulla base delle ricerche che sono state effettuate precedentemente da uno stesso utente. Ogni volta che effettuiamo una ricerca con Bing, l’informazione fornita aiuta il motore stesso a capire cosa stiamo cercando. Più effettuiamo ricerche e clicchiamo su un certo risultato, più Bing impara e può usare queste informazioni per fornirci le risposte più attinenti, che vengono visualizzate in maniera più evidenziata rispetto alle altre.

Dal punto di vista SEO, appare chiaro che Bing Adaptive Search ha la capacità di influenzare il traffico verso il vostro sito. Supponiamo ad esempio che vendiate solo attrezzature per il golf e che siate ottimamente posizionati per questo termine. Può succedere che dopo un certo periodo di tempo diventi chiaro a Bing che alcuni utenti, digitando la parola chiave golf, siano interessati alle news sul golf e non all’acquisto della attrezzatura. Bing modificherà allora i risultati delle SERP per questi utenti, con il risultato che il vostro sito verrà scavalcato nel posizionamento dai siti di news sul golf.

Verrete invece favoriti nel posizionamento per quegli utenti che ricercano, con la keyword golf, le attrezzature per questo sport.

Riassumendo l’algoritmo adaptive search ha come obiettivo quello di fornire una lista di risultati rilevanti per l’utente, sulla base delle ricerche effettuate da ogni utente. Quindi personalizzare le SERP attraverso le esperienze di ricerca.

Questo articolo sugli “algoritmi dei motori di ricerca” è stato pubblicato in data 7 luglio 2016. I diversi algoritmi vengono aggiornati di frequente, per cui alcune delle informazioni che troverete potrebbero cambiare. Sarà mia cura mantenere il più possibile attuale questo articolo, anche attraverso degli approfondimenti.