Quali sono le principali tecniche SEO?

La SEO può essere suddivisa approssimativamente in tre sotto-gruppi: SEO On-Page, SEO Off-Page e SEO Tecnica (Technical SEO). La SEO On-Page è il contenuto e i tag HTML. La SEO Off-Page è principalmente costituita dall’implementazione di strategie che servono ad ottenere backlink. La SEO Tecnica riguarda l’accessibilità del tuo sito web.

SEO Off-Page e SEO On-Page

Questo articolo vuole affrontare la tematica della “Technical SEO”, ma prima di fare ciò vediamo brevemente sia la “SEO Off-Page” che la “SEO On-Page” (per un approfondimento leggete anche l’articolo tecniche SEO)

La SEO Off-Page si riferisce alle azioni intraprese al di fuori del tuo sito web per influenzare il tuo posizionamento all’interno delle pagine dei risultati dei motori di ricerca (SERP). In particolare comporta l’utilizzo di strategie per l’acquisizione e la gestione di backlinks da fonti autorevoli e pertinenti alle tematiche trattate nel vostro sito al fine di aumentarne la popolarità e autorevolezza agli occhi dei motori di ricerca.

Le più importanti tecniche SEO Off-Page sono:

- Content Marketing

- Citazioni (Link Building e Link Earning);

- Menzioni;

- Recensioni;

- Social Media

- Podcast

- Google My Business;

La SEO On-Page è la pratica di ottimizzazione del contenuto della pagina Web per i motori di ricerca e gli utenti. Le tecniche SEO On-Page più comuni sulla pagina includono: ottimizzazione del tag TITLE e Meta Tag, ottimizzazione di tag H, ottimizzazione delle immagini, scrittura di contenuti di qualità e pertinenti, collegamenti interni e ottimizzazione URL.

Per favorire un migliore posizionamento sui motori di ricerca occorre utilizzare tutte le tecniche previste per i 3 sotto-gruppi SEO. Tuttavia la technical SEO deve essere considerata prioritaria, in quanto occorre costruire una solida base tecnica per il sito web prima di caricarlo di contenuti e promuoverlo con strategie di backlink.

Argomenti sulla Technical SEO affrontati nell’articolo

In questo articolo analizzeremo tutti gli aspetti collegati all’ottimizzazione del sito al fine di aiutare i motori di ricerca a trovare, scansionare e indicizzare in maniera corretta le pagine del sito web, ottimizzandone la struttura, e migliorando la velocità di caricamento delle pagine e l’accessibilità.

Si possono identificare 12 passaggi:

- Verifica indicizzazione sito web;

- Risoluzione dei problemi di indicizzazione;

- Controllo della struttura del sito;

- Ottimizzazione del crawl budget (insieme di risorse che il motore di ricerca decide di dedicare a un determinato sito web);

- Eliminazione dei contenuti duplicati;

- Testare e migliorare la velocità della pagina;

- Utilizzare un approccio “mobile-first”;

- Controllare il contenuto HTTPS;

- Aggiungere dati strutturati;

- Rivedere la mappa del sito (sitemap xml);

- Chiedere a Google di eseguire nuovamente la scansione del sito;

- Controllare il sito regolarmente (Site Audit).

Verificazione indicizzazione del sito Web

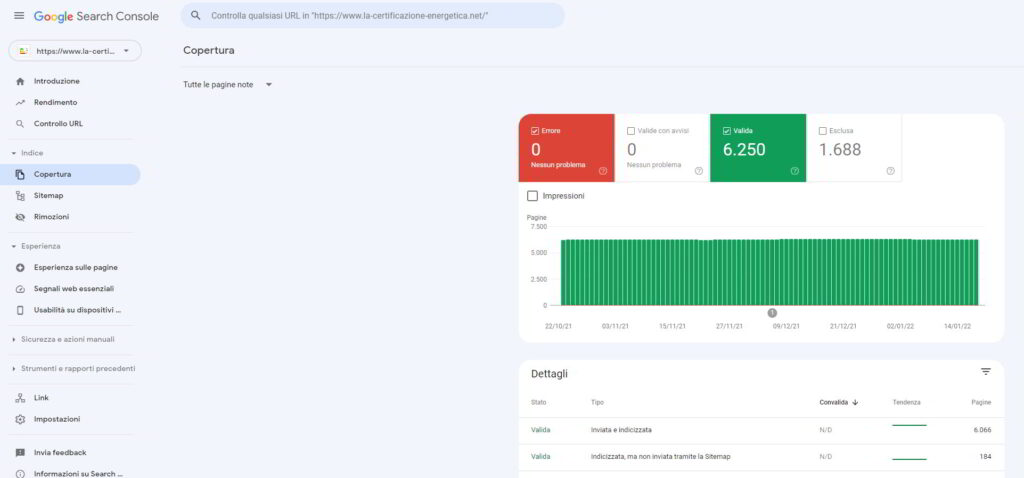

La verifica dell’indicizzazione del sito web è il primo step da cui partire. Il tuo sito web è indicizzato? Appare nella lista dei risultati (SERP) dei motori di ricerca? La prima cosa da fare è cercare su Google il nome del dominio e verificare se appare tra i risultati di ricerca. Se il sito web appare nella SERP, il secondo passaggio è quello di vedere se il sito è effettivamente entrato nell’indice di ricerca. A tal fine possiamo utilizzare come strumento la Google Search Console, visualizzando il rapporto sulla copertura:

Il rapporto mostra quante delle pagine sono attualmente indicizzate, quante sono escluse e quali sono alcuni dei problemi di indicizzazione trovati nel sito web. Il numero di pagine indicizzate dovrebbe essere vicino al numero effettivo di pagine del sito. Ad esempio nel caso di un e-commerce, il numero di pagine indicizzate dovrebbe corrispondere al numero di prodotti caricati.

Risoluzione dei problemi di indicizzazione

In generale, ci sono due tipi di problemi di indicizzazione. Uno è quando una pagina non è indicizzata anche se dovrebbe esserlo. L’altro è quando una pagina viene indicizzata anche se non dovrebbe esserlo. Se stai utilizzando Google Search Console per controllare il sito web, il primo tipo di problema di indicizzazione verrà generalmente contrassegnato come un errore. Gli errori di indicizzazione si verificano quando si chiede a Google di indicizzare una pagina, ma la stessa è bloccata. Ad esempio, una pagina è stata aggiunta a una mappa del sito, ma è contrassegnata con il tag noindex o è bloccata con robots.txt. Per risolvere il problema occorre prima verificare se la pagina dovrebbe essere indicizzata e, nel caso di risposta positiva, rimuovere tutto ciò che la sta bloccando. In caso negativo, rimuovere la pagina dalla mappa del sito.

L’altro tipo di problema di indicizzazione è quando la pagina viene indicizzata, ma Google non è sicuro che dovesse essere indicizzata. In Google Search Console queste pagine sono generalmente contrassegnate come valide con avvisi. Questi tipi di problemi di indicizzazione di solito si verificano quando hai provato a bloccare la pagina utilizzando le istruzioni robots.txt. È un errore molto comune pensare che robots.txt possa bloccare l’indicizzazione della pagina. In realtà, Google è libero di ignorare queste istruzioni. Se vuoi davvero bloccare la pagina devi usare il tag noindex.

Controllo della struttura del sito (Site-Audit)

Una struttura del sito poco profonda (con pochi livelli di navigazione e con una struttura a link interni per organizzare il contenuto) e correttamente progettata è importante per gli utenti e i robot dei motori di ricerca. Inoltre, i collegamenti interni aiutano a trasferire, tutto o in parte, il valore del ranking (il cosiddetto link juice) tra le pagine in modo più efficiente.

Ottimizzazione del crawl budget

Analizzare lo stato del crawling (scansione) di un sito web è uno degli aspetti più importanti di un SEO Audit. Capire il modo in cui le risorse vengono acquisite, elaborate e processate dai software di scansione dei motori di ricerca è un requisito fondamentale per l’ottimizzazione di qualsiasi progetto online. Il crawl budget (CB) è il numero di pagine che i motori di ricerca scansionano in un determinato periodo di tempo. Il crawl budget non è un fattore di ranking di per sé, ma determina la frequenza con cui le pagine del sito vengono scansionate (e se alcune di esse vengono sottoposte a scansione).

A seconda dell’importanza del tuo sito web, Google metterà a disposizione per la scansione del sito una certa finestra temporale. Tanto maggiore saranno il numero di risorse che il crawler riesca ad analizzare in un determinato periodo di tempo, più alto sarà il numero di pagine sottoposte a scansione ogni giorno.

Appare chiaro che l’obiettivo è quello di ottimizzare il crawl budget in modo che tutte le pagine importanti di un sito web o di un E-commerce vengano scansionate. Il detto “il tempo è denaro” calza proprio a pennello. In che modo possiamo ottenere questo risultato?

Per migliorare il crawl budget possiamo compiere le seguenti azioni:

- ridurre i contenuti di scarsa qualità (sempre utilizzando lo strumento Google Search Console – Rendimento – possiamo individuare le pagine che ottengono pochi clic e/o poche impression, valutando se rimuoverle del tutto oppure aggiornarle, migliorandone i contenuti);

- ignorare le risorse a bassa priorità (è comune utilizzare gif, meme e video per rendere più accattivanti le tue pagine. L’utilizzo di queste risorse è pensato per intrattenere gli utenti, ma in realtà non sono importanti per i motori di ricerca. Si può chiedere a Google, attraverso la modifica del file robots.txt, di ignorare queste risorse e di eseguire la scansione di altre);

- evitare i reindirizzamenti (quando ci sono troppi reindirizzamenti, Google di solito smette di seguire il percorso e si sposta su altre parti del sito web. Ciò significa che alcune delle tue pagine potrebbero non essere mai scansionate. Occorre quindi eliminare le pagine con più di 2 reindirizzamenti;

- ridurre al massimo tutte le pagine con status code 3xx, 4xx e 5xx (quando un bot di ricerca raggiunge una pagina 4XX/5XX, una parte del Crawl Budget viene sprecata. Ecco perché è importante trovare e correggere tutti i collegamenti interrotti sul tuo sito);

- gestire le Url Dinamiche (è normale che i sistemi di gestione dei contenuti generino molte URL dinamiche. Fondamentalmente, ciascuna delle tue pagine può avere URL diversi a seconda di come ci sei arrivato o dei tipi di filtri che hai utilizzato. Google potrebbe visualizzare ciascuno di questi URL come una pagina diversa, anche se il contenuto è per lo più lo stesso. Per impedire a Google di eseguire la scansione di un gruppo di pagine quasi identiche, puoi chiedergli di ignorare determinati parametri URL);

- ridurre il Time To First Byte (il TTFB è il valore utilizzato per misurare la reattività di un web server, ovvero il tempo trascorso dalla richiesta HTTP del client alla ricezione del primo byte della pagina. Tale valore per essere accettabile deve rimanere tra 0.1 e 0,5 secondi. Può essere misurato utilizzando gli strumenti messi a disposizione sul seguente sito WebPageTest. I consigli che posso darvi sono quelli di utilizzare un buon servizio di Hosting, usare un metodo di caching “respond first”, ottimizzare il codice dell’applicazione, usare una CDN. Vi consiglio, per un approfondimento. un articolo che trovate al seguente link: Cosa significa TTFB);

- ridurre il Time To Last Byte (il TTLB è la velocità con cui il web server fornisce le risorse al client, ovvero il tempo necessario al client per ricevere l’ultimo byte della chiamata HTTP. Un valore ottimale è inferiore a 0,5 secondi. Ridurre il TTLB significa migliorare la velocità e la prestazione del server;

- ridurre i contenuti dipendenti da JavaScript per una maggiore velocità di caricamento delle pagine;

- controllare la sitemap e equilibrare il profilo dei backlink.

Eliminazione dei contenuti duplicati

Il contenuto duplicato non è un grosso problema per la SEO, ma può dare luogo ad alcuni problemi. Se sul tuo sito web sono presenti due o più pagine quasi identiche, quale deve essere indicizzata? Cosa succede se Google decide che i tuoi duplicati sono un segno di plagio o spam? È meglio non rischiare, rimuovendo queste pagine o nascondendole ai motori di ricerca.

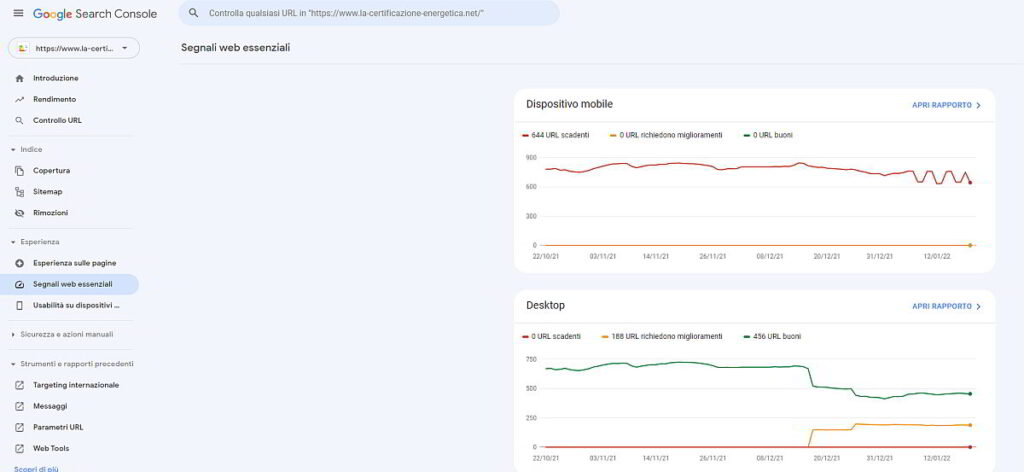

Testare e migliorare la velocità della pagina

La velocità di caricamento ottimale di una pagina web dovrebbe essere inferiore a due secondi. Se non lo è occorre ovviamente portare avanti delle azioni per migliorarla. Tuttavia, la velocità della pagina non è una cosa facile da misurare. Google utilizza per la misurazione della velocità di una pagina Core Web Vitals, tre metriche progettate per misurare la velocità percepita di una determinata pagina. Le metriche sono Largest Contentful Pain (LCP), First Input Delay (FID) e Cumulative Layout Shift (CLS). In Google Search Console, nel rapporto Segnali web essenziali, vengono indicate le prestazioni delle pagine del tuo sito in base a dati sull’utilizzo reali, basandosi sulle tre metriche indicate prima. Tempi di caricamento delle pagine più lunghi hanno un effetto negativo sulle frequenze di rimbalzo.

Utilizzare un approccio “mobile-first”

Nel 2018, dopo un anno e mezzo di attenta sperimentazione e test, Google ha iniziato a migrare i siti all’indicizzazione mobile-first. Gli algoritmi impostano i motori di ricerca per eseguire la scansione delle versioni mobili dei siti Web anziché delle versioni desktop. E questo significa letteralmente che la versione mobile delle tue pagine determina come si posizionano nei risultati di ricerca sia per dispositivi mobili che desktop. Il test ottimizzato per dispositivi mobili di Google include una selezione di criteri di usabilità, come la configurazione del viewport, l’uso di plug-in e la dimensione del testo e degli elementi cliccabili. È anche importante ricordare che la compatibilità mobile viene valutata in base alla pagina, quindi occorre controllare ciascuna delle tue pagine di destinazione per la compatibilità mobile separatamente, una alla volta.

Per valutare l’intero sito web è meglio passare a Google Search Console. Nella scheda “Esperienza sulle pagine”, troverai il rapporto sull’usabilità mobile per tutte le pagine. Sotto il grafico è presente una tabella con i problemi più comuni che interessano le tue “pagine mobile”. Puoi indagare ulteriormente cliccando su uno qualsiasi dei problemi.

Controllare il contenuto HTTPS

Google ha iniziato a utilizzare HTTPS come segnale di ranking nel 2014. Da allora, le migrazioni HTTPS sono diventate sempre più comuni. Oggi, secondo il Rapporto sulla trasparenza di Google, il 95% dei siti Web di Google utilizza HTTPS. Se il tuo sito non è ancora diventato HTTPS, potresti prendere in considerazione una migrazione HTTPS. Se il tuo sito utilizza già HTTPS (parzialmente o interamente), è importante verificare i problemi comuni di HTTPS come parte dell’audit SEO del sito. In particolare, ricordati di controllare:

- Contenuti misti (i problemi di contenuto misto sorgono quando una pagina HTTPS carica parte del suo contenuto (immagini, video, script, file CSS) su una connessione HTTP non sicura. Ciò indebolisce la sicurezza della pagina e potrebbe impedire ai browser di caricare il contenuto non sicuro o addirittura l’intera pagina);

- Canonical e Redirect (per prima cosa occorre verificare la presenza di versioni HTTP e HTTPS duplicate delle tue pagine. Se le versioni HTTP e HTTPS del tuo sito Web non sono impostate correttamente, entrambe possono essere indicizzate dai motori di ricerca contemporaneamente. Ciò causerà problemi di contenuti duplicati che potrebbero danneggiare il posizionamento del tuo sito web. Idealmente, tutti i collegamenti sul tuo sito HTTPS, così come i reindirizzamenti e i canonici, dovrebbero puntare immediatamente alle pagine HTTPS. In secondo luogo, anche se hai i reindirizzamenti da HTTP a HTTPS implementati correttamente sull’intero sito, non devi portare gli utenti verso reindirizzamenti non necessari: questo farà apparire il tuo sito molto più lento di quanto non lo sia in realtà. Tali reindirizzamenti possono essere un problema anche per la scansione, poiché sprecherai un po’ del tuo crawl budget ogni volta che un bot del motore di ricerca trova un reindirizzamento);

Aggiungere dati strutturati

I dati strutturati sono essenzialmente codice HTML utilizzato per “taggare” elementi specifici sulla tua pagina. Ad esempio, se la tua pagina è una ricetta di torta di mele, puoi dire a Google quali sono gli ingredienti, il tempo di cottura, il conteggio delle calorie e così via. Google può quindi utilizzare i tag per creare “rich snippet” per le tue pagine in SERP. Abbiamo affrontato questo discorso in maniera più approfondita nel seguente articolo: Rich Snippet.

Rivedere la mappa del sito (sitemap)

La sitemap fornisce ai motori di ricerca informazioni sulla struttura del tuo sito e consente loro di scoprire nuovi contenuti. Se hai un sito, ma non hai mai creato una sitemap, è giunto il momento di farlo, altrimenti Google difficilmente scoprirà la tua esistenza. Quando controlli la tua mappa, assicurati che sia:

- Pulita. La mappa deve essere libera da errori, reindirizzamenti e URL bloccati dall’indicizzazione; in caso contrario, rischi che i motori di ricerca ignorino la mappa del sito come se non fosse presente. Per questo motivo utilizza sempre un tool (ce ne sono anche di gratuiti) per la sua costruzione. Se il sito è composto da centinaia di pagine il consiglio è quello di acquistare la versione a pagamento (io uso ad esempio “A1 Sitemap Generator”);

- Aggiornata. Assicurati che la mappa del sito sia aggiornata ogni volta che un nuovo contenuto viene aggiunto o rimosso: questo aiuterà i motori di ricerca a scoprire nuovi contenuti velocemente;

- Concisa. Google non eseguirà la scansione delle Sitemap oltre 50.000 URL. La SEO può essere suddivisa approssimativamente in tre sotto-gruppi: SEO On-Page, SEO Off-Page e SEO Tecnica (Technical SEO)Idealmente, dovresti mantenerla molto più breve di così per assicurarti che le tue pagine più importanti vengano scansionate più spesso: esperimenti SEO tecnici mostrano che mappe del sito più brevi danno luogo a scansioni più efficaci;

- Caricata in Google Search Console. Fai conoscere a Google la tua mappa del sito. Puoi inviarla manualmente a Google Search Console o specificarne la posizione in qualsiasi punto del file robots.txt.

Chiedere a Google di eseguire nuovamente la scansione del sito

Attraverso l’audit del sito potrebbero essere messi in evidenza alcuni problemi che devono essere risolti. Una volta corretti, puoi chiedere esplicitamente a Google di eseguire nuovamente la scansione delle tue pagine per assicurarti che le modifiche vengano prese in considerazione il prima possibile. Questa operazione può essere fatta sempre attraverso la Google Search Console con l’aiuto dello strumento di “Controllo degli URL”, immettendo l’URL della pagina di cui eseguire nuovamente la scansione e richiedendo una nuova indicizzazione.

Prima di eseguire tale operazione valuta bene se è davvero necessario forzare la ripetizione della scansione. Ad esempio, dopo aver introdotto seri cambiamenti nel sito: hai spostato il tuo sito da http a https, introdotto dati strutturati o ottimizzato i contenuti essenziali; oppure vuoi che un post urgente del blog appaia su Google più velocemente. La ripetizione della scansione può richiedere da 10 minuti a diverse settimane.

C’è un’opzione simile anche in “Bing Strumenti per i Webmaster”. Una volta inserita l’URL che desideri reindicizzare, Bing eseguirà la scansione in pochi minuti. Lo strumento consente ai webmaster di inviare fino a 10.000 URL al giorno per la maggior parte dei siti.

Controllare il sito regolarmente (Site Audit)

Un controllo regolare del sito dovrebbe essere una priorità nella tua strategia SEO. Qualunque cambiamento appaia sul Web, potrebbe influenzare il posizionamento delle tue pagine in modo imprevedibile. Ecco perché è davvero importante impostare strumenti di analisi per controlli tecnici regolari per rilevare i problemi SEO e risolverli non appena emergono. Puoi eseguire l’automazione dell’audit del sito utilizzando anche tools professionali, che ovviamente hanno un costo, ma riducono notevolmente il tempo necessario all’analisi completa di tutti i parametri che posso influenzare il posizionamento del tuo sito.